Die CES 2022, es war klar, dass AMD mit irgendwas Paroli bieten muss gegen den 12900K von Intel. Gesprochen wird hier von einem, in der oberen Mittelklasse angesiedelten, Prozessor namens 5800X3D.

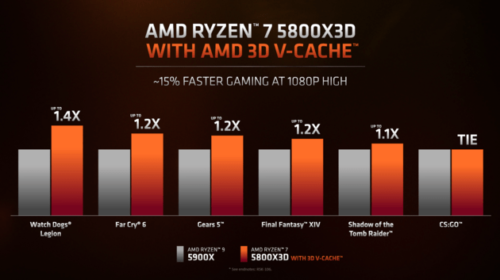

Laut eigenen AMD Folien schlägt der 5800X3D selbst den 5900X in Spielen teils recht deutlich, wenn aber auch nicht massiv. Auffällig ist hier CS:GO, also ein älteres Spiel.

Reine Taktraten sind also immer noch interessant, auch wenn viele Spiele inzwischen besser auf mehreren Kernen skalieren. Dazu aber gleich mehr.

Quelle:AMD

Quelle:AMD

Der 5800X3D kommt jetzt mit 96MB statt 32MB Cache daher, gleichzeitig ändern sich aber auch die Taktraten. Also von 4,7GHz auf 4,5GHZ. Schuld ist wohl der dreifach „gestackte“ Cache, der natürlich auch Temperaturen erzeugt die irgendwie abgeführt werden müssen. Und da der 5800X3D ebenfalls nur mit einem Chiplet (für die CPU’S) daherkommt ist das Temperaturproblem, also der Hotspot, derselbe geblieben. Da der 5900X generell höher boostet ist das Geheimnis wohl gelöst warum der der 5800X3D da eine Pattsituation erreicht. Also Patt, hey, ein Patt. Vier Kerne weniger, damit acht Threads, weniger Taktrate, und trotzdem den 5900X schlagen? DAS ist eine Nummer. Wobei man sagen muss, dass der 5900X niemals für’s reine Gaming konzipiert wurde. Aber, der Ryzen scheint ordentlich mit dem Cache zu performen.

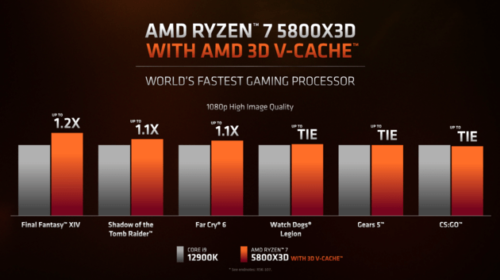

Kommen wir zu dem Flaggschiff von Intel. Dem 12900K. Und nein, hier greift kein „Flaggschiff“ aka 5900X oder 5950X an, sondern ein 5800X3D. Nur halt mit dreifachem Cache. Und siehe da, Intel wurde eingeholt, wenn wohl auch nicht geschlagen. Hier und da mal ein Gleichstand, hier und da mal vorne. Wobei man sagen muss die Folien seitens AMD sind mit Vorsicht zu genießen. Aber zumindest mit dem Release von ZEN3 lagen sie sehr nah dran, warum also auch hier nicht?

Quelle:AMD

Quelle:AMD

Zu sagen bleibt, evtl. wird es keine 5900X3D oder 5950X3D geben, das ist bisher unklar. Würde aber auch irgendwie Sinn machen, aufgrund Chipknappheit erst einmal die Gamer bedienen, die mitnichten einen 5900X3D kaufen würden, und da „abgrasen“ wo Kohle generiert wird.

AMD hat aufgeholt, Intel aber nicht massiv geschlagen. Was zu erwarten war. Was aber nicht ersichtlich war ist die Tatsache mit einem „kleinen“ Achtkerner um die Ecke zu kommen und so eine Nummer zu bringen. Bleibt die Preisfrage, und die Effizienz. Im Frühjahr, wie AMD es sagt, also ein weiter Begriff, ist mit diesen Prozessoren zu rechnen. Also irgendwie was um den April/Mai rum. Und dann werden es Benchmarks zeigen, wir werden es sehen, irgendwann…

AMD hat das Teil im übrigen schon verlinkt: 5800x3d

Intel wartet wohl schon, mit dem 12900KS^^

Vielleicht übersehe ich ja was, aber nach dem Datenblatt zu urteilen, müsste man den 5800X3D eher mit einem Ryzen 7 statt mit einem Ryzen 9 vergleichen (natürlich ist die Leistung im Vergleich zu einem Ryzen 9 ein Hammer! Wenn AMD dann noch eine entsprechende CPU mit 16 Kernen herausbringt ….).

Schön wäre bei einem Test auch den 5800X3D mit einem 5950X mit Videobearbeitung (DaVinci, Adobe Premiere) zu vergleichen – 8 gegen 16 Kerne … Natürlich beide mit einer aktuellen NVIDIA Graka.

Ein wenig enttäuscht bin ich auch vom unterstützen Speicher. Der i12900K unterstützt doch schon DDR5 ….

Der 5800X3D ist ein Prozessor für AM4 und da gibt es nunmal kein DDR5. Der Prozessor soll ja auch mit dem 4XX-Chipsatz kompatibel sein…

Soll jetzt etwa extra für den Prozessor noch neue Boards mit DDR5 kommen, wo am Ende der Leistungszuwachs des RAM aber viel zu niedrig ausfällt. Lohnt doch gar nicht.

Ist alles richtig – nur wenn schon eine „Antwort auf Intel“ dann bitte nicht kleckern sondern klotzen

Denn wenn ich eh schon einen 5950X verbaut habe, was sollte mich motivieren die CPU zu wechseln?

Entweder dies hat mehr Leistung (Upgrade von 5950X) oder ist bei gleicher Leistung billiger (upgrade von einem schwächeren Ryzen 7). Aber schauen wir einmal was noch kommen wird

Verstehe mich nicht falsch – im Moment bin ich dabei mir ein System mit AMD 5950X und NVIDIA 3090 zu konfigurieren … Jetzt kommt AMD mit einer neuen CPU – um diese anstatt der 5950X zu nehmen, muss diese bei gleicher Leistung günstiger sein oder sonst mehr können… Da ich eh neu konfiguriere ist es mir egal welches MB ich verwende .

Warum keine Radeon GPU? Ich würd eher e RX6900XT empfehln, anstatt so e Geforce da….

gepostet mit der Deskmodder.de-App für Android

Na weil z.b. von DaVinci die NVIDIA besser unterstützt wird. Fürs Gaming mag es anders aussehen.

Könntest du das auch begründen?

Wenn die Kohle locker sitzt ist die RTX 3090 ein no-brainer. Schon allein wegen DLSS und Raytracing, da schmatzt die RX6900 ordentlich ab oder unterstützt es nicht(DLSS)

Nur Hörensagen – bzw. Aussagen von BlackMagix dass DaVinci optimal für NVIDIA konzipiert wäre …

Es gibt aber auch Berichte die behaupten dass eine „interne Intel HD Grafik super funktioniert“ – was immer mit „super funktioniert“ gemeint ist …

Selbst habe ich Erfahrung eben mit einem i5 mit Intel HD Grafik – ja funktioniert, aber von „super“ meilenweit entfernt. Dann einem i7 mit NVIDIA 960 und nun 1660Ti – kein Vergleich zur Intel HD! – die 1660Ti hat dank H264/265 Codierungsunterstützung mit CUDA nochmals einen deutlichen Performanceschub gebracht – die 960er konnte nur opencl und war deutlich langsamer. Soweit ich das in Erfahrung brachte, soll die AMD auch „nur“ opencl können? Na ja und mein neues NB hat nun einen Ryzen 7 mit einer RTX3060 – kein Vergleich zum i7 PC mit der 1660Ti!

Ich bin jetzt in der Situation meinen alten i7 PC zu erneuern /aufzurüsten… und habe die Wahl:

– AMD Ryzen 9 mit NVIDIA 3090 neues MB

– Intel 12900k mit NVIDIA 3090 und DDR5 RAM neues MB

– warten was noch kommt… AMD soll doch noch eine neue CPU mit Sockel AM5 und DDR 5 Unterstützung etc. noch heuer auf den Markt bringen…

Mir ist nicht wichtig welche Leistung das System/die Grafikkarte beim Spielen hat, sondern was das System beim Videoschnitt bringt! Einige Operationen verlangen nach möglichst viel CPU Kernen, bei anderen kann man gar nicht genug RAM und Video-Ram haben (deshalb ja auch die 3090er mit 24GB und keine Graka mit „nur“ 12gb – Berichten zu folge haben diese User damit auch bei einigen Operationen Fehlermeldungen von wegen zu wenig Speicher – 64GB RAM, Graka mit 12GB!).

Mit der Begründung hab ich eigentlich Tom gemeint Du machst mit der Geforce alles richtig. Davinci profitiert ab Version 17 auch von den Tensor-Kernen um das Arbeiten noch mehr zu beschleunigen. Und Videospeicher kann man eigentlich nie genug haben, wenn ich mir den VRAM-Hunger in Fusion anschaue…

Du machst mit der Geforce alles richtig. Davinci profitiert ab Version 17 auch von den Tensor-Kernen um das Arbeiten noch mehr zu beschleunigen. Und Videospeicher kann man eigentlich nie genug haben, wenn ich mir den VRAM-Hunger in Fusion anschaue…

ne günstige AM4 Rdna 2 APU wäre schon noch nett gewesen.