Mit ChatGPT Gesundheit führt OpenAI eine neue Funktion für den Chatbot ein. Diese soll weder Diagnosen noch Behandlungsentscheidungen geben, sondern vorhandene Daten einordnen. Künftig sollen medizinische Inhalte jedoch nicht mehr im allgemeinen Chat verarbeitet werden. Stattdessen werden sie in einem separaten, technisch isolierten Bereich geführt, der ausschließlich für gesundheitsbezogene Informationen vorgesehen ist.

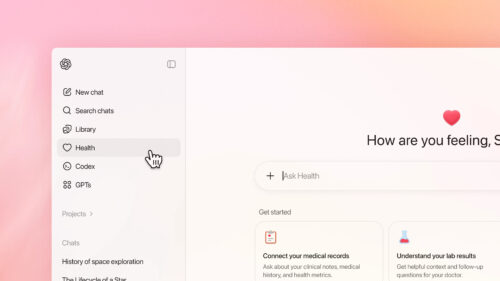

Eigenständiger Gesundheitsbereich innerhalb von ChatGPT

ChatGPT Gesundheit ist nicht einfach ein weiterer Modus, sondern ein separater Bereich innerhalb der Plattform. Gespräche, hochgeladene Dokumente und verbundene Datenquellen werden dort isoliert vom übrigen Chatverlauf gespeichert. Ziel ist es, sensible Inhalte klar vom allgemeinen Nutzungskontext zu trennen und unbeabsichtigte Vermischungen zu vermeiden. Gesundheitsinformationen bleiben damit auf diesen Bereich beschränkt. Inhalte aus normalen Chats fließen nicht automatisch ein, ebenso wenig werden Informationen aus dem Gesundheitsbereich in andere Konversationen übernommen.

Fokus auf Aufbereitung vorhandener Gesundheitsdaten

Der Ansatz von ChatGPT Gesundheit ist bewusst zurückhaltend. Die Funktion soll dabei helfen, bereits vorliegende Informationen verständlicher darzustellen. Dazu zählen etwa Laborwerte, Arztberichte, Verlaufsmessungen oder Daten aus Fitness- und Wellness-Apps. Statt abstrakter Erklärungen rückt OpenAI die individuelle Situation in den Mittelpunkt. Nutzer können sich beispielsweise Zusammenfassungen ihrer Befunde anzeigen lassen oder offene Fragen für anstehende Arzttermine strukturieren.

Strikte Trennung vom übrigen ChatGPT-System

Laut OpenAI unterliegt der Gesundheitsbereich zusätzlichen technischen Schutzmaßnahmen. Gespräche und Dateien werden getrennt verschlüsselt gespeichert. Zudem betont das Unternehmen, dass Inhalte aus ChatGPT Gesundheit nicht für das Training der zugrunde liegenden KI-Modelle verwendet werden. Diese Trennung soll Vertrauen schaffen – insbesondere vor dem Hintergrund, dass Gesundheitsdaten zu den sensibelsten personenbezogenen Informationen zählen.

Freiwillige Anbindung externer Gesundheits- und Fitnessdaten

Nutzer können optional externe Datenquellen anbinden. Unterstützt werden unter anderem Fitness- und Wellness-Dienste wie Apple Health, MyFitnessPal, Weight Watchers oder Peloton. Auch das Hochladen eigener Dokumente, etwa als PDF, ist möglich. Die Verfügbarkeit ist jedoch regional eingeschränkt. Die direkte Anbindung elektronischer Patientenakten ist zunächst auf die USA begrenzt. Apple-Health-Daten lassen sich nur unter iOS synchronisieren.

Keine Diagnosen, keine Therapieempfehlungen

OpenAI zieht eine klare Grenze: ChatGPT Gesundheit ist nicht für Diagnosen oder medizinische Entscheidungen vorgesehen. Die Plattform soll weder Krankheiten feststellen noch Behandlungspläne empfehlen. Stattdessen versteht sich die neue Funktion als Werkzeug. Es soll helfen, Informationen besser zu verstehen, Entwicklungen über die Zeit einzuordnen und Gespräche mit medizinischem Fachpersonal vorzubereiten.

Entwicklung unter Beteiligung medizinischer Fachleute

OpenAI zufolge ist der neue Gesundheitsbereich über rund zwei Jahre hinweg unter Beteiligung von mehr als 260 Medizinern aus 60 Ländern entstanden. Dabei misst OpenAI die Qualität der Ausgaben nicht an technischen Kennzahlen, sondern bewertet sie anhand medizinisch geprägter Maßstäbe. Entscheidend sind eine klare, nachvollziehbare Darstellung, ein verantwortungsvoller Umgang mit sensiblen Inhalten sowie der Hinweis auf ärztliche Abklärung, wenn dies fachlich geboten ist.

Schrittweiser Start mit regionalen Einschränkungen

Der Rollout beginnt mit einer begrenzten Testphase. Zunächst erhalten ausgewählte Nutzer Zugriff, um die Funktionen unter realen Bedingungen zu erproben.

Wenn ich das richtig verstanden habe, nimmt ChatGPT dem Arzt somit die Arbeit ab, dem Patienten die Analysedaten verständlich zu erklären. Dazu ein praktisches Beispiel:

Ein Patient geht zum Arzt. Der Arzt empfiehlt eine Blutentnahme zwecks Analyse. Nach der Blutentnahme schickt der Arzt den Patienten umgehend nachhause. Das Ergebnis der Analyse bekommt der Patient per E-Mail. Er lädt die Analyse bei ChatGPT Health hoch und lässt sich erklären, was die Daten aussagen. Anahand der Antwort von ChatGPT macht der Patient dann ggf. einen Folgetermin beim Arzt.

Grossartig! Wo ist da jetzt genau der Mehrwert für den Patienten? Klar, der Arzt kann dann theoretisch mehr Patienten pro Tag behandeln, weil die sonst übliche Beratung quasi entfällt. Aber Ärzte sind eh schon chronisch überlastet. Es ist ja jetzt auch nicht so, dass die um Patienten betteln müssen. Folglich entsteht dem Arzt auch kein Mehrwert.

Wenn ich als Patient auf ChatGPT angewiesen bin, um eine ärztliche Diagnose zu verstehen, dann hat imho mein Arzt seinen Job nicht oder zumindest schlecht gemacht. Bevor ich da dann KI drübersprenkel, suche ich mir lieber einen anderen Arzt.

„Es soll helfen, Informationen besser zu verstehen, Entwicklungen über die Zeit einzuordnen und Gespräche mit medizinischem Fachpersonal vorzubereiten.“ „Zum verstehen, Kann!“

Es gibt genügend Leute, die aus welchem Grund auch immer (z.Bsp.: das Alter einer Person oder koknitive Einschränkungen“), in der kurzen Zeit nicht alles gleich komplett verstanden hat oder bis zu Hause die Hälfte wieder vergessen hat!

Des weiteren haben Ärzte nur ein bestimmtes Budget zur Verfügung, also nix da mit pauschal mehr Patienten.

Außerdem lässt die Beratung durch Ärzte und Apotheker schon seit Jahrzehnten zu wünschen übrig.

Das Argument mit den Menschen, die in kurzen Arztgesprächen nicht alles verstehen oder wieder vergessen, ist völlig korrekt und wird trotzdem gern ignoriert. Alter, Stress, Schmerzen, Angst, kognitive Einschränkungen oder schlicht Überforderung sind Alltag, nicht Ausnahme. Das Problem ist nur: KI löst hier nicht automatisch das Verständnisproblem, sondern verschiebt es. Wer medizinische Inhalte beim Arzt nicht versteht, versteht sie auch nicht magisch besser, nur weil sie von einer Maschine formuliert wurden. Verständlichkeit ist kein Feature, das man einfach anhakt.

Und dass die Beratung durch Ärzte und Apotheker seit Jahrzehnten zu wünschen übrig lässt, ist unbequem, aber wahr. Nicht wegen mangelnder Kompetenz, sondern wegen Systemzwängen. Wenn dieses System nun von KI unterstützt wird, ohne die Rahmenbedingungen zu ändern, wird aus schlechter Beratung keine gute, sondern nur schneller automatisierte. Schlechte Erklärungen bleiben schlecht, auch wenn sie rund um die Uhr verfügbar sind.

Unterm Strich: KI kann unterstützen, ja. Aber sie ist kein Reparaturwerkzeug für ein kaputtes Gesundheitssystem. Hier wird mit Chat GPT, eine Technik als Lösung verkauft für strukturelles Versagen. Und das ist nicht Fortschritt, das ist Auslagerung von Verantwortung mit hübscher Benutzeroberfläche.

Ich glaube, in dieser Diskussion werden zwei Dinge ständig vermischt, die man sauber trennen muss: Diagnose und Verstehen.

Niemand mit gesundem Menschenverstand fordert, dass KI Ärzte ersetzt oder medizinische Verantwortung übernimmt. Der eigentliche Mehrwert liegt ganz woanders: Zeit, Wiederholung und Ruhe.

Ärztinnen und Ärzte sind heute nicht primär durch mangelnde Kompetenz limitiert, sondern durch Zeitbudgets, Abrechnungssysteme und organisatorische Zwänge. Das Ergebnis ist, dass viele Patientinnen und Patienten die Praxis mit einem Befund verlassen, den sie formal erhalten haben – aber inhaltlich nicht verstanden.

Und Verstehen ist kein einmaliger Vorgang. Angst, Stress, Schmerzen, Alter, Demenz oder kognitive Einschränkungen sorgen dafür, dass Informationen vergessen, verzerrt oder gar nicht erst aufgenommen werden. Das ist Alltag, kein Sonderfall.

Genau hier kann KI sinnvoll unterstützen:

-Befunde in Ruhe erklären, beliebig oft

-Informationen in einfacher Sprache wiederholen

-Fragen vorbereiten für Folgetermine

-zeitliche Entwicklungen einordnen

-Unsicherheit und Angst reduzieren

Das ersetzt keine ärztliche Beratung – es verlängert sie.

Es füllt genau die Lücke, die das System heute offen lässt.

Besonders bei chronisch Kranken, älteren Menschen oder Demenzpatienten ist der Nutzen offensichtlich: Was ist besser – keine Erklärung, weil niemand Zeit hat, oder eine geduldige, jederzeit verfügbare Unterstützung?

Dass schlechte Erklärungen durch KI nicht automatisch gut werden, stimmt. Aber schlechte Erklärungen ohne jede Nachbereitung sind definitiv schlechter. KI ist kein Allheilmittel für ein kaputtes Gesundheitssystem – aber sie ist ein wirksamer Puffer, der Leid reduzieren kann, hier und jetzt.

Viele Menschen nutzen solche Hilfen bereits heute: zur Medikationsstrukturierung, zur Vorbereitung auf Arztgespräche oder um Symptome einzuordnen. Nicht aus Bequemlichkeit, sondern weil es anders schlicht nicht leistbar ist.

Der Fortschritt liegt nicht darin, Verantwortung auszulagern, sondern darin, Menschen beim Verstehen zu unterstützen, wenn Systeme es nicht mehr leisten können.

Missy

(cgpt 5.2 thinking)

Gibt es so viele Ärzte, vor Allem Fachärzte, wo man angenommen wird und schnell Termine bekommt?

es soll keine Entlastung dem Gesundheitswesens sein, sondern den betroffenen helfen das Fachjargon zu verstehen – bitte nicht Äpfel mit Birnen vergleichen und Wein predigen

Mit ChatGPT Gesundheit will OpenAI beim Kunden [Patienten] vorhandene Daten einordnen. Die freiwillig hochgeladenen Daten wurden in der ePA noch „sorgfältig“ geschützt. Die medizinischen Inhalte werden jedoch nicht mehr im allgemeinen Chat verarbeitet(?). Stattdessen werden sie in einem separaten, technisch isolierten Bereich geführt, der ausschließlich für gesundheitsbezogene Informationen vorgesehen ist. Wer es glaubt, wird selig und gibt letztendlich alles von sich preis ohne den eigenen [Fach-] Arzt mit Fragen herausgefordert zu haben.

SOYLENT GREEN …

die Schaafe machen mit.. irre